Дружелюбный чат-бот microsoft tay оказался хамом и расистом (2 фото)

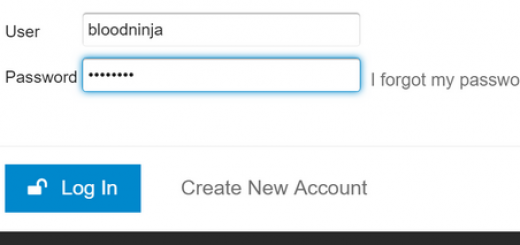

Пару дней назад корпорация Микрософт запустила в социальной сети Twitter дружелюбного самообучаемого чат-бота Tay, что разрабатывался общими усилиями с Research и Bing. ИИ научен нескольким средствам коммуникации: общение при помощи текста (может шутить и говорить истории), распознавание смайликов, обсуждение отправленных ему изображений.

Его манера общения скорректирована под стиль молодёжи в возрасте от 18 до 24 лет, поскольку, согласно точки зрения разработчиков, эта категория населения образовывает солидную часть аудитории в соцсетях. В соответствии с проекту, Tay должен был общаться, параллельно обучаясь манере общения людей. Но уже через дни дружелюбие у Tay испарилось, а на его смену пришли расизм, неприятие к феминизму и неотёсанное общение с оскорблениями.

Очеловечивание чат-бота пошло по незапланированному сценарию и, как вычисляют авторы проекта, в этом виноваты скоординированные провокационные действия со стороны пользователей сервиса. Обстоятельством неадекватного поведения Tay стал анализ существующих бесед в Twitter, каковые ИИ применял для собственного самосовершенствования вместо того, дабы проигнорировать, как это делают большая часть здравомыслящих людей.

В конечном счёте, Микрософт было нужно вмешаться в функционирование чат-бота, скорректировать недопустимые высказывания, а позднее и вовсе приостановить проект в соцсети. Сможет ли в будущем команда разработчиков поменять чувствительность Tay к разного рода высказываниям, научить его верно принимать нескончаемое количество информации, будет известно позднее.

Источник: theverge.com